FunClip:开源的AI视频自动化视频剪辑工具

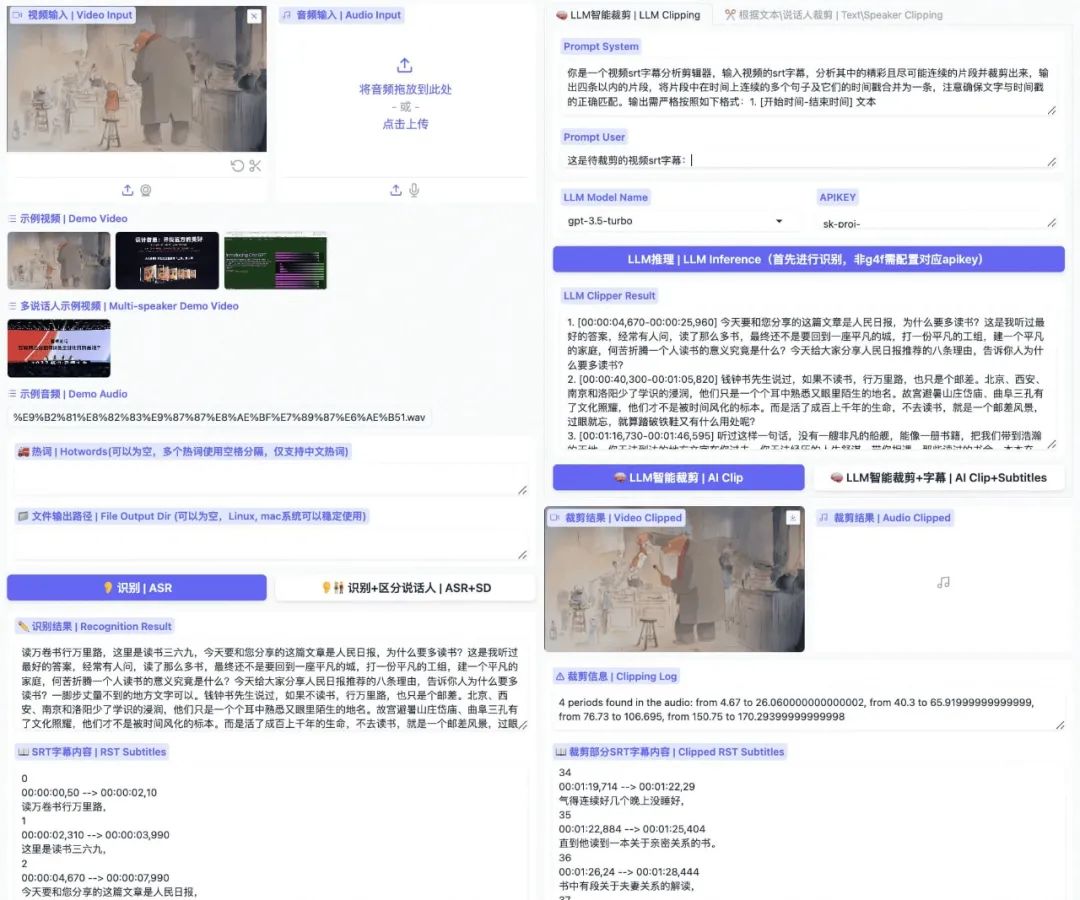

FunClip 是阿里巴巴通义实验室开源的一款视频剪辑工具,基本实现了基于 LLM 与音视频交互的能力,包括分主题分段、字幕识别、识别说话人、智能剪辑、快速导航。它能够自动识别视频中的中文语音并允许用户根据语音内容来裁剪视频。工具使用了阿里巴巴语音识别模型FunASR、 Paraformer-Large确保了剪辑的精准性。

FunClip主要能力

1.高精度语音识别

利用阿里巴巴开源的 Paraformer-Large模型进行视频中的中文语音识别,该模型是当前市场上识别效果最佳的开源中文ASR模型之一.

支持热词定制化功能,可以在语音识别过程中定制特定的实体词、人名等,以提高识别的准确度。

2.视频裁剪与剪辑

·用户可以基于语音识别结果选择特定的文本片段或者说话人,进行视频的精确裁剪

集成 CAM++说说话人识别模型,使得用户可以根据自动识别出的说话人ID来选择裁剪的视频段落。

3.用户界面与交互

通过 Gradio 界面提供的交互式平台,用户可以方便地上传视频、设置参数并进行剪辑。

界面友好,安装简单,使用户即使没有编程背景也能轻松使用。

4.功能扩展性

支持多段视频的自由剪辑,并能自动生成全视频及目标段落的SRT字幕,便于后续处理,计划集成英文视频剪辑能力和大语言模型,进一步拓宽工具的应用范围和功能。

FunASR主要能力

FunASR 是阿里巴巴通义实验室推出的一个综合性语音识别工具包,它提供了从语音信号到文本的端到端解决方案,集成了多个高性能的预训练模型。该工具包旨在连接学术界与工业应用之间的桥梁,具备广泛的功能:

1. 语音识别(ASR):提供非自回归端到端模型,如Paraformer-Large,这类模型在准确率、效率和部署便捷性方面表现出色。支持多任务处理,覆盖多语言识别、语音翻译和语言识别等。

2. 语音活动检测(Voice Activity Detection, VAD):通过预训练模型有效地区分语音与非语音段落,提升语音处理的效率。

3. 标点恢复(Punctuation Restoration):自动为转写的文本添加标点符号,提高阅读的流畅性。

4. 模型部署与优化:支持模型的微调和推理服务,无论是文件转录还是实时转录服务,都能在CPU和GPU等不同平台上灵活部署。

Paraformer模型能力

Paraformer 是由阿里巴巴达摩院语音团队研发的一种非自回归端到端语音识别模型,专为GPU并行推理优化,提供快速而准确的语音转文本能力。该模型在处理长音频方面表现出色,整合了VAD、ASR、标点以及时间戳功能。Paraformer的关键特点包括:

1. 高效模型架构:其架构灵活性高,Encoder部分可选用多种网络结构,如self-attention、conformer、SAN-M等。Predictor负责预测目标文本长度和提取相应声学向量;Sampler无参数,转换声学和目标向量;Decoder采用双向模型设计,提高效率和准确度;Loss Function结合了交叉熵、MWER(最小词错误率)和Predictor的MAE(平均绝对误差)目标。

2. 功能拓展:支持热词定制,通过增强特定词汇的识别来提高模型在特定领域的表现;长音频模型能处理数小时的音频,输出带有标点和时间戳的文本。

3. 应用场景广泛:适用于多种场景,如语音输入法、语音导航、智能会议记录等,既支持非实时的录音文件解码,也支持实时语音识别,即时输出文本。

FunClip以独特的语音识别与智能剪辑技术,不仅简化了传统视频编辑流程,更为各行业带来了前所未有的创作灵活性和效率。随着对英文视频剪辑和大语言模型的支持逐步实现,其应用领域将更加宽广,持续推动内容创作的边界,激发更多的创新灵感和可能性。

参考网址:

GitHub: https://github.com/alibaba-damo-academy/FunClip

在线演示:https://modelscope.cn/studios/iic/funasr_app_clipvideo/summary

GitHub:https://github.com/alibaba-damo-academy/FunASR

FunASR论文:https://arxiv.org/abs/2305.11013

Paraformer论文:https://arxiv.org/abs/2308.03266