"InternLM-XComposer2:掌握自由文本-图像合成与理解,视觉语言大型模型"

InternLM-XComposer2: Mastering Free-form Text-Image Composition and Comprehension in Vision-Language Large Model论文解读

大纲:

1. 引言

- 简要介绍多模态大型语言模型的发展背景及该模型的创新之处。

2. 相关工作

- 简要介绍大语言模型和多模态语言模型的发展现状。

3. 模型方法

- 详细介绍模型的架构设计,包括视觉编码器、语言模型和部分LoRA模块。

- 描述模型的预训练过程和微调过程,包括使用的数据集和任务。

4. 实验结果

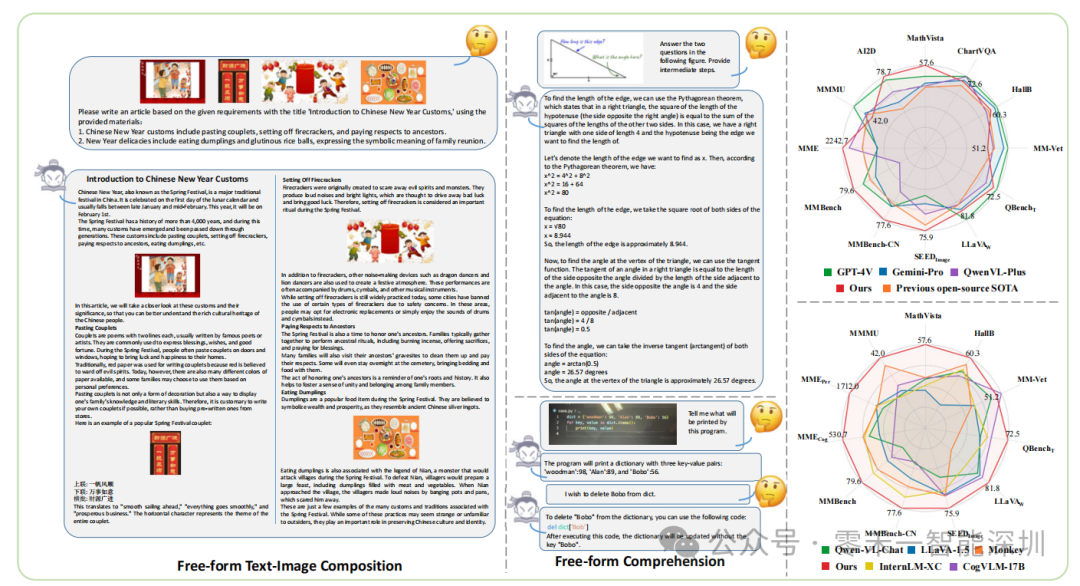

- 展示模型在生成任务和多模态理解任务上的性能表现,并与现有模型进行对比。

- 展示模型的生成结果和对话结果,以说明其能力。

5. 结论与展望

- 总结模型的优势和贡献,展望未来研究方向。

6. 参考文献

论文中关键知识点如下:

1. **多模态大型语言模型**:将视觉和语言特征映射到同一特征空间,实现视觉语言的理解、生成和对话。

2. **视觉编码器**:提取图像的高层语义特征,常用的包括基于卷积神经网络和基于Transformer的编码器。

3. **大语言模型**:采用Transformer架构,通过大量数据预训练来获得强大的语言理解能力。

4. **部分LoRA**:为新的模态(如视觉)添加额外的LoRA参数,在保留语言模型知识的同时实现模态对齐。

5. **数据集**:包括图像字幕数据、多任务数据、自由形式组合数据,用于模型的预训练和微调。

6. **多模态理解**:在数学视觉问答、多模态理解基准测试集上,评估模型的性能。

7. **内容生成**:利用模型根据用户需求生成自定义的文本和图像内容。

8. **性能评估**:比较模型与现有开源模型和商业API模型在多模态理解任务上的性能表现。

9. **应用前景**:模型可用于生成自定义的多模态内容,为未来多模态语言模型的发展提供了有力支持。

评论:

1. **模型创新点**:该模型结合了视觉编码器和强大的语言模型,并通过部分LoRA技术实现图像和语言的有效对齐。这种创新设计使模型在视觉理解和文本生成方面都表现出色。

2. **数据集创新点**:模型使用了高质量的图像字幕数据和多任务数据,以及根据用户需求生成的自由形式组合数据。这种丰富的数据集为模型提供了强大的视觉语言理解和内容生成能力。

3. **性能表现**:在数学视觉问答、多模态理解基准测试集上,该模型的性能优于现有开源模型,甚至与商业API模型相当或略胜一筹,展现了其强大的多模态理解能力。

4. **应用前景**:该模型可以用于根据用户需求生成自定义的多模态内容,为未来多模态语言模型的研究和应用提供了有力支持。

5. **不足之处**:尽管模型在性能上表现优异,但仍有改进空间,包括提升视觉理解和复杂推理能力,以进一步提升多模态理解表现。

6. **未来发展**:未来可以通过引入更多高质量的数据、优化模型架构等方式来进一步提升模型的表现。

综上所述,该模型在多模态理解和生成方面实现了创新,展现出了强大的多模态理解能力,但仍有一些改进空间。