动手实现对抗生成网络

实现一个GAN(生成对抗网络)模型涉及到多个步骤,以下是一个基本的指南。请注意,这只是一个基础的框架,实际实现时可能需要根据具体的应用和数据集进行调整。

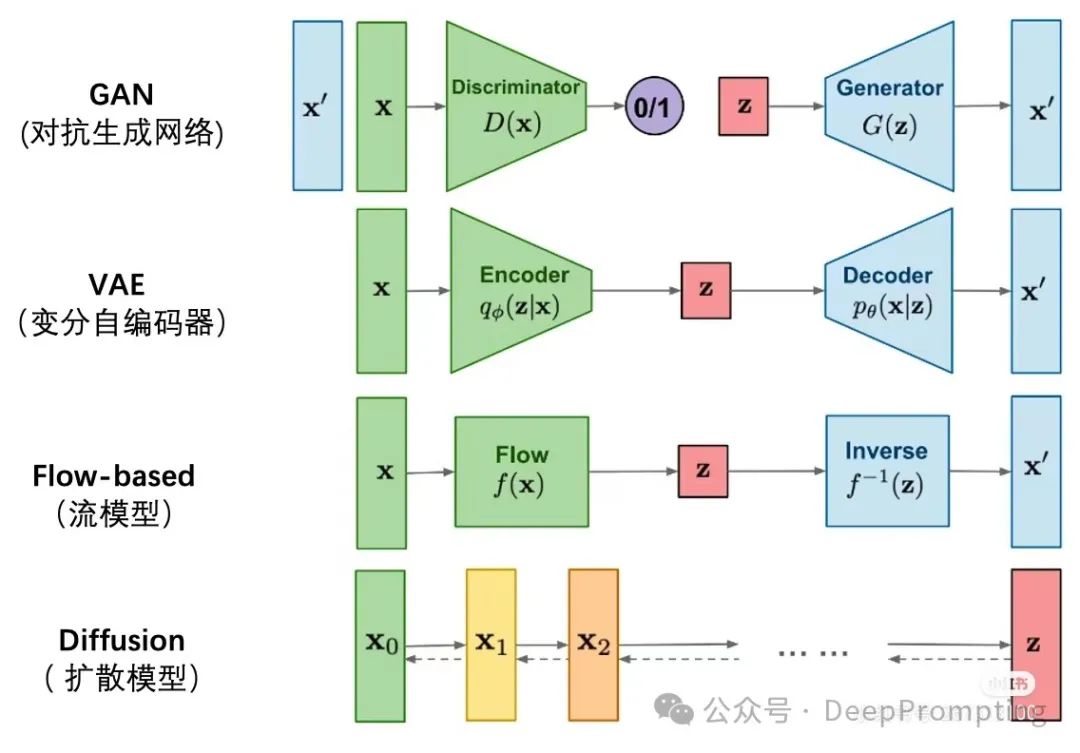

理解GAN的基本原理:

GAN由两个神经网络组成:生成器(Generator)和判别器(Discriminator)。

生成器的任务是生成尽可能接近真实数据的假数据。

判别器的任务是区分输入数据是真实的还是由生成器生成的。

这两个网络通过竞争和合作的方式共同进化,最终生成器能够生成非常逼真的假数据。

准备数据集:

选择一个适合GAN任务的数据集。GAN通常用于图像生成任务,因此图像数据集是常见的选择。

对数据进行预处理,如归一化、调整尺寸等。

构建生成器网络:

生成器通常是一个卷积神经网络,用于从随机噪声中生成图像。

网络的输入是一个随机噪声向量,输出是生成的图像。

网络的结构可以根据具体任务和数据集进行调整。

构建判别器网络:

判别器是一个卷积神经网络,用于区分输入图像是真实的还是生成的。

网络的输入是图像,输出是一个概率值,表示输入图像是真实的概率。

同样,网络的结构可以根据具体任务和数据集进行调整。

定义损失函数和优化器:

GAN的损失函数包括两部分:生成器的损失和判别器的损失。

生成器的损失通常基于判别器对生成图像的判断,目标是让判别器难以区分生成图像和真实图像。

判别器的损失则基于其对真实图像和生成图像的判断,目标是尽可能准确地区分它们。

选择合适的优化器,如Adam或RMSprop,来优化网络参数。

训练GAN:

在训练过程中,交替更新生成器和判别器的参数。

首先固定生成器的参数,训练判别器以区分真实图像和生成图像。

然后固定判别器的参数,训练生成器以生成能够欺骗判别器的图像。

重复这个过程多次,直到达到满意的生成效果。

评估和调整:

使用适当的评估指标来评估GAN的性能,如生成的图像质量、多样性等。

根据评估结果调整网络结构、损失函数或优化器参数,以改进GAN的性能。

保存和使用模型:

训练完成后,保存生成器和判别器的模型参数。

使用生成器来生成新的图像或进行其他相关任务。

请注意,GAN的训练过程可能比较复杂和不稳定,需要耐心调整和优化。此外,还有一些高级的GAN变体(如DCGAN、WGAN等)可以提供更好的性能和稳定性,可以根据具体需求进行选择和学习。

当然可以,以下是一个使用PyTorch实现的基本GAN模型的代码示例。这个示例中,我们假设我们正在处理28x28像素的灰度图像,比如MNIST数据集。

请注意,这只是一个基础示例,用于演示GAN的基本结构和工作原理。在实际应用中,您可能需要根据具体任务和数据集来调整网络结构、超参数和训练策略。

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

# 定义超参数

input_dim = 784 # 输入维度,对于28x28的图像是784

hidden_dim = 256 # 隐藏层维度

output_dim = 784 # 输出维度

num_epochs = 200 # 训练轮数

learning_rate = 0.0002 # 学习率

batch_size = 64 # 批处理大小

sample_interval = 400 # 生成样本的间隔

# 定义数据加载和预处理

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))

])

dataset = datasets.MNIST('./data', train=True, download=True, transform=transform)

dataloader = DataLoader(dataset, batch_size=batch_size, shuffle=True)

# 定义生成器和判别器

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.main = nn.Sequential(

nn.Linear(input_dim, hidden_dim),

nn.ReLU(True),

nn.Linear(hidden_dim, hidden_dim),

nn.ReLU(True),

nn.Linear(hidden_dim, output_dim),

nn.Tanh()

)

def forward(self, input):

output = self.main(input)

output = output.view(-1, 1, 28, 28)

return output

class Discriminator(nn.Module):

def __init__(self):

super(Discriminator, self).__init__()

self.main = nn.Sequential(

nn.Linear(output_dim, hidden_dim),

nn.LeakyReLU(0.2, inplace=True),

nn.Linear(hidden_dim, hidden_dim),

nn.LeakyReLU(0.2, inplace=True),

nn.Linear(hidden_dim, 1),

nn.Sigmoid()

)

def forward(self, input):

input = input.view(-1, output_dim)

output = self.main(input)

return output

# 初始化生成器和判别器

generator = Generator()

discriminator = Discriminator()

# 定义损失函数和优化器

criterion = nn.BCELoss()

optimizer_G = optim.Adam(generator.parameters(), lr=learning_rate)

optimizer_D = optim.Adam(discriminator.parameters(), lr=learning_rate)

# 训练GAN

for epoch in range(num_epochs):

for i, (real_images, _) in enumerate(dataloader):

# ---------------------

# 训练判别器

# ---------------------

# 使用真实图像更新判别器

optimizer_D.zero_grad()

real_labels = torch.ones(batch_size, 1)

fake_labels = torch.zeros(batch_size, 1)

outputs = discriminator(real_images)

d_loss_real = criterion(outputs, real_labels)

real_score = outputs

# 生成假图像并更新判别器

noise = torch.randn(batch_size, input_dim)

fake_images = generator(noise)

outputs = discriminator(fake_images.detach())

d_loss_fake = criterion(outputs, fake_labels)

fake_score = outputs

# 反向传播并优化

d_loss = d_loss_real + d_loss_fake

d_loss.backward()

optimizer_D.step()

# ---------------------

# 训练生成器

# ---------------------

# 生成假图像并尝试欺骗判别器

optimizer_G.zero_grad()

noise = torch.randn(batch_size, input_dim)

fake_images = generator(noise)

outputs = discriminator(fake_images)

g_loss = criterion(outputs, real_labels)

# 反向传播并优化

g_loss.backward()

optimizer_G.step()

print(f'Epoch [{epoch+1}/{num_epochs}], Step [{i+1}/{len(dataloader)}], d_loss: {d_loss.item():.4f}, g_loss: {g_loss.item():.4f}')

# 如果达到指定的间隔,则生成并保存样本图像

if (epoch+1) % sample_interval == 0:

with torch.no_grad():

fake_images = generator(torch.randn(10, input_dim))

# 将图像从Tensor保存到文件

# 这里省略了保存图像的代码,您可以使用matplotlib或PIL库来保存图像

# 保存模型(如果需要)

# torch.save(generator.state_dict(), 'generator.pth')

# torch.save(discriminator.state_dict(), 'discriminator.pth')

请注意,上面的代码是一个简化的示例,仅用于演示GAN的基本结构和工作原理。在实际应用中,您可能需要对网络结构、损失函数、优化器等进行更精细的调整,以获得更好的性能。此外,GAN的训练过程通常非常不稳定,并且可能需要大量的实验和调整才能找到适合您任务的最佳配置。

入群学习与交流人工智能和AI Infra