生成式AI的技术路线

点击蓝字 关注我们

当下,生成式AI炙手可热!我们见到的ChatGPT、文生图、文生视频等都是生成式AI。

总体上来说,生成式AI有三大技术路线:

自回归模型(AR)、

非自回归模型(NAR)、

混合模型(AR+NAR)。

简介

最新成果

2024年2月15日,OpenAI的Sora正式对外发布。一经发布,Sora就震惊了全世界。Sora是一个【文生视频大模型】:输入一段文本描述,Sora就能生成一个相应的视频。视频效果非常惊艳!

OpenAI关于Sora的技术报告名字叫做《Video generation models as world simulators》,可见OpenAI的雄心壮志 --- 用视频生成技术来模拟世界,打破现实世界与虚拟世界之间的界限!

视频生成是生成式AI的一种场景,所以我们今天来聊一聊生成式AI的技术路线!

技术路线

当前,生成式AI有三大技术路线:

一是自回归(AR,Autoregressive)模型,Hungyi Lee老师称之为【各个击破】;

二是非自回归(NAR,Non-autoregressive),Hungyi Lee老师称之为【一步到位】;

三是AR和NAR的混合模型。

自回归模型(AR)

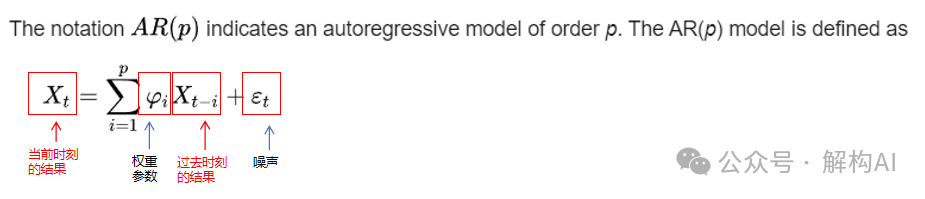

AR模型的定义

AR就是根据1, ..., t-1时刻的数据,预测t时刻的输出。也就是说,根据之前时刻的数据,预测当前时刻的输出。所以,也称为各个击破。其数学公式如下:

公式中t时刻的结果与其前个时刻的数据相关。AR在时间序列处理中也有重要应用。

AR模型的生成过程

大语言模型(LLM,Large Language Model)也简称大模型。大语言模型就是自回归模型。

ChatGPT是最知名的大语言模型之一,其生成过程如下图所示。

示例:

用户提问:“世界最高的山是什么?”

生成模型:“珠穆朗玛峰”

生成这个答案的详细过程如下:

图1 自回归语言模型的生成过程

第一步,把问题“世界最高的山是什么?”输入模型,模型预测出下一个字:“珠”;

第二步,把【问题 + 已经生成的结果】,也就是【“世界最高的山是什么?珠”】,输入模型,模型预测出下一个字:“穆”;

依次类推,直到最后生成结束符“END”,表示生成过程结束。

非自回归模型(NAR)

NAR模型的定义

非自回归模型就是一次性生成整个结果,没有中间的多个迭代步骤。所以也称为一步到位。

NAR模型的生成过程

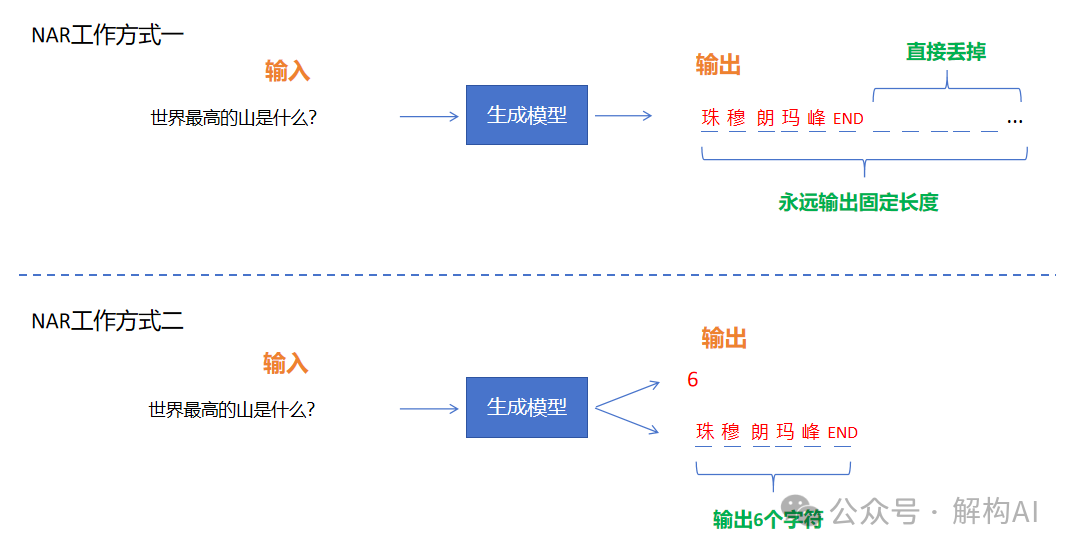

依然以文字生成举例,如下图2所示。

图2 非自回归语言模型的生成过程

还是同样的问题:“世界最高的山是什么?”,输入模型,直接生成结果“珠穆朗玛峰”。

NAR模型的生成长度

这里有一个问题:NAR怎么判断生成过程的结束呢?

AR模型中,每次生成下一个词,这个过程重复迭代,直到出现“END”,生成过程结束。

但在NAR中,问题不同,那生成的答案也会长短不一。NAR模型怎么知道当前这个问题答案有多长呢?如果不知道答案的长短,模型怎么知道这次要生成多长的内容?

NAR的两种工作方式

针对这个问题,有两个解决方案,我们称其为NAR的两种工作方式。如图2所示。

NAR工作方式一:模型只生成固定长度的答案。这个答案中从“END”标记往后的部分直接丢弃。保留从开始到END的部分作为最终的答案。当然,如果真实的答案超过了这个固定长度,则生成的答案会不完整。

NAR工作方式二:模型不仅生成答案,还要事先预测答案的长度;再根据这个长度生成最终的答案。当然,长度和答案可以一次性生成,也可以分两步完成。示例中,模型先生成了答案的长度6,再生成6个字符作为答案。

AR与NAR的优缺点

可以看出,

AR生成速度慢,但是质量好。

NAR生成速度快,但是质量差。

因为AR可以更好地利用局部性假设:相邻的两个结果,相关性强。AR可以充分利用这一特性:看到上一步生成了“珠”,那下一步生成“穆”的可能性就会大增。而NAR中“珠”和“穆”是同时生成的,“珠”字不能为“穆”字的生成提供更多的参考。所以,NAR的质量比AR要差。

文本生成常用自回归模型AR,因为文本一般都不太长。

影像生成常用非自回归模型NAR。因为影像往往很大,使用AR的话,效率太低。比如一幅1024x1024的图片,它共有一百万个像素,如果使用AR一个一个像素按顺序生成,则需要迭代一百万次!这个过程太慢了!

NAR可以并行,适合分布式计算。AR中后一步对前一步有依赖,只能串行。

混合模型AR+NAR

把AR与NAR结合起来,让它们取长补短。既保证有好的生成质量,又保证有高的生成速度。

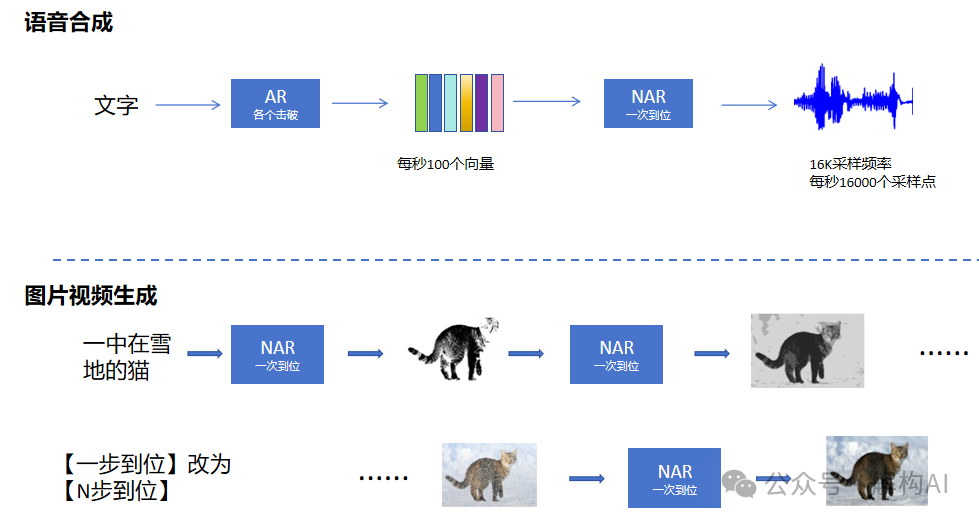

图3 AR + NAR混合使用

语音合成:采用了AR+NAR混合使用的路线。先将文字通过AR模型生成中间向量,比如每秒100个向量。再根据中间向量,使用NAR模型生成语音信号。

图片及视频生成:也采用了AR+NAR混合使用的路线。首先使用NAR模型生成一幅模糊的图片;然后再使用NAR模型基于上一步图片的基础上生成更清晰的图片;如此重复N步,最后得到清晰的目标图片。这其实就是扩散模型(Diffusion Model)的技术方案。

如此,则既能保证生成的质量,又能保证生成的速度。

Reference

1. Hung-Yi Lee老师的课程《生成式学习的两种策略》

2. https://openai.com/research/video-generation-models-as-world-simulators

3. InstructTTS: http://dongchaoyang.top/InstructTTS/

4. https://en.wikipedia.org/wiki/Autoregressive_model

END

说明及版权声明

说明:本文部分素材来自网络公开资料,由作者重新编写,系作者个人观点,本平台发布仅为了传达一种不同观点。如果由任何问题,请联系小编:Hello AI新世界。